l dibattito sulla regolamentazione dell’Intelligenza Artificiale in Europa e in Italia ha riunito esperti di diverse discipline per analizzare temi cruciali come l’etica, la sicurezza, la governance e l’impatto sul lavoro, con l’obiettivo di affrontare i rischi e i bias insiti in queste tecnologie. La necessità primaria che emerge è quella di adottare un’idea di responsabilità, discutendo l’agire sociale dominante e “riflettendo criticamente sulla nostra vita contemporanea”. Questa riflessione si colloca in una prospettiva disciplinare semioetica, che permette di osservare il principio di antroposemiosi auspicato nel Libro Bianco, e in una prospettiva transdisciplinare che conduce a riflessioni ai confini tra i saperi.

Lo sviluppo tecnologico si collega strettamente alla tutela dei diritti fondamentali degli individui, quelle libertà sancite nei primi 54 articoli della Costituzione, come il diritto alla privacy e il diritto alla salute. In quanto linguista e analista comportamentale, mi preme discutere proprio sul principio di equità, un fattore determinante nei modelli di apprendimento automatico utilizzati per supportare il processo decisionale in applicazioni ad alto rischio come i prestiti ipotecari, le condanne al carcere e le assunzioni. Esistono software, operanti in ambito bancario, giuridico e nel mondo del lavoro, che spesso vengono utilizzati dagli operatori in maniera inconsapevole; allo stesso modo, esistono software che sono addirittura open source.

L’uso combinato delle tecnologie dell’IA con biotecnologie, scienze mediche e ingegneria genetica è ormai dominante nella nostra società. È quindi urgente interrogarsi e trovare risposte sulle implicazioni che garantiscano il rispetto dei diritti umani e sulle evoluzioni della cultura tecno-etica e della coscienza sociale, le quali hanno già prodotto un cambiamento profondo della nostra esperienza culturale, non solo in termini di accesso e produzione. Da una prima riflessione su questi temi è derivato un capitolo, “I profili applicativi dell’I.A. nelle disabilità: le comunità sorde”, che ha evidenziato, in un quadro di discipline a contatto, il quadro legislativo, i rischi e la tutela del disabile, come accade per la biometria e la sorveglianza.

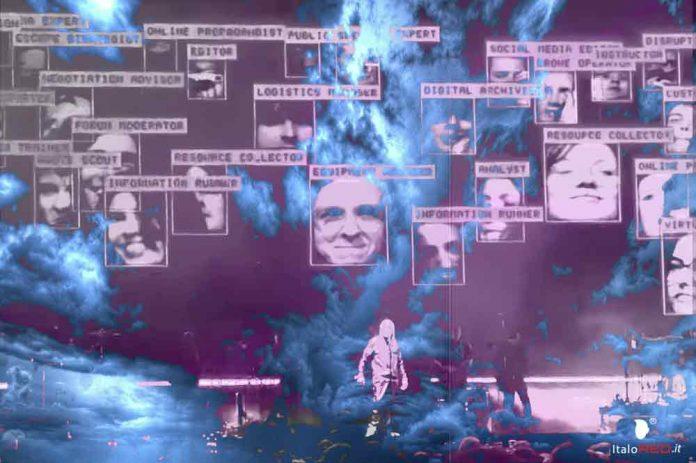

Questo tema mi è particolarmente caro poiché constatiamo che è ancora irrisolto un nodo cruciale. Nell’AI Act, il quale vieta l’utilizzo dei sistemi telematici di riconoscimento biometrico in tempo reale all’interno di spazi pubblicamente accessibili con fini di applicazione della legge, troviamo una presa di posizione importante. Nella normazione dei settori, suddivisa per livelli di rischio, l’identificazione biometrica remota in tempo reale, come il riconoscimento facciale negli spazi pubblici per fini di legge, e il riconoscimento delle emozioni in contesti specifici come i luoghi di lavoro o gli istituti di istruzione, sono infatti classificate come pratiche di sistemi a rischio inaccettabile e dunque vietate. In modo provocatorio, durante il loro tour 2025, la band dei Massive Attack ha proiettato durante il brano “Girl I Love You” i volti del pubblico con i relativi dati sensibili e biometrici, usando un software realizzato da United Virtual Artist, per sensibilizzare proprio su questa “iper-espansione del capitalismo della sorveglianza”.

L’impatto sociale e culturale dell’IA, così forte e radicato, conferma quanto teoricamente il prof. Luciano Floridi definisce “infosfera”, popolata da “inforg”, organismi informazionali costantemente immersi in un luogo virtuale e agenti passivamente attivi, sempre connessi in una nuova sfera interattiva. Essi agiscono in un luogo dove le barriere tra off-line e on-line sono sempre più labili, originando l’onlife. In una prospettiva semioetica e con uno sguardo attento al rispetto, soprattutto nei confronti di comunità e minoranze, occorre colmare quei buchi nell’attribuzione della responsabilità, il cosiddetto “responsibility gap”, che non permettono di distinguere soggetti operanti e persone, per superare le situazioni in cui è difficile attribuire la responsabilità di operazioni algoritmiche.

Un altro aspetto nodale è quello della gestione e del controllo dei dati, un territorio conteso tra settore pubblico e privato e ancora non adeguatamente regolamentato. Questa mancanza ci ha condotto verso uno stato di sorveglianza irresponsabile, che Baudrillard ha chiamato “stato video”, in cui la vita nella videosfera manipola l’identità individuale imprigionandola nei nuovi media. Una volta entrati nel mondo come sua duplicazione, i media non sono più distinguibili da esso e questa indistinzione dialettica è ciò che Marco Senaldi chiama obversione.

Il nuovo stato di coscienza e identità umana dell’uomo “Interneticus” è quello di una macchina post-umana, risultato di una mutazione antropologica, un nuovo Inforg, organismo informaticamente incarnato, immerso in una “betweenness” o “intercapedine”, come nuova dimensione esistenziale tra il mondo materiale e immateriale, in cerca di un equilibrio in questa nuova dimensione post-digitale. Cultura, società, imprese e letteratura sono oggi composte da nuovi discorsi e pratiche virali in cui soggetti vecchi e nuovi creano nuovi linguaggi. La libertà deve essere raggiunta attraverso dispositivi che hanno invaso la vita quotidiana, dando origine, negli ultimi anni, a un vasto spazio immateriale che si combina con quello fisico e in cui la gente spende una quantità crescente di tempo, uno spazio liquido e liscio dove si originano nuove forme di beni e nuove disidentità panoptiche. Questa condizione deve essere superata, cercando di evitare di far parte dei processi di I.A. come un semplice soggetto passivo.

il ruolo delle emozioni che ha caratterizzato l’uso delle tecnologie di IA, generando nuovi settori come quello dell’affective computing e dell’emotion AI. Un capitolo è dedicato ai profili applicativi dell’IA, le microespressioni e la comunicazione non verbale, per esplorare i nuovi rapporti tra inforg people e nuove figure dotate di IA. Questo studio critico mi ha condotto verso una definizione che ho denominato pensiero ‘tecnocritico’, in cui nuove narrazioni verbali e non verbali si combinano. Fondamentale in questo percorso è stato lo scambio con il dott. Ernesto Di Iorio, CEO di Questit, azienda italiana specializzata in tecnologie proprietarie di IA, e con il prof. Eugenio Iorio dell’Università Sant’Orsola Benincasa.

Nell’era tecnocratica, in cui viviamo una vita sempre più connessa e onlife, e dialoghiamo con umanoidi e chatbot, cambiano anche le regole che gestiscono i comportamenti e le relazioni. Gli schemi emotivi comportamentali, che seguono il percorso stimolo-risposta, hanno indicatori verbali e non verbali a partire dai quali gli stimoli generano determinate reazioni. La codifica e decodifica di queste componenti hanno momenti ben definiti e scientificamente identificati. L’uso dell’IA nel riconoscimento di tali segnali fornisce un valido supporto sociale e comunicativo, ma persistono numerosi bias, ben delineati nell’AI Act. Questo appare evidente quando si parla di interfacce utente multimodali, mirate a migliorare l’esperienza nell’interazione uomo-macchina, dotate di infinite capacità di percezione basate su diversi canali comunicativi.

Nell’AI Act è ben evidente la necessità di partire dalla consapevolezza che l’IA è uno strumento potentissimo che, se disciplinato, può evitarne usi impropri e decisioni sbagliate. Oltre ai bias cognitivi legati ai dati di addestramento, occorre indagare la logica applicativa connessa alla capacità percettiva e di elaborazione di queste macchine. Tecnologie di edge computing possono essere una soluzione straordinaria per i bias legati alla privacy, risolvendo by design il problema del trattamento dei dati personali. Uno studio approfondito di queste componenti conduce alla nuova idea di “tecnocritica”, che vede nel bias non più un semplice pregiudizio mentale inconscio, ma una tipica specificità, una “singolarità tecnologica” intesa come tratto distintivo del sentire e pensare umano. Questa visione potrebbe condurre a una pacifica convivenza e ibridazione comunicativo-comportamentale.

La soluzione è chiara: servono regole trasparenti, protezione dei dati e responsabilità etica. Usare l’IA significa usare bene ciò che può migliorare la vita, evitando abusi e ambiguità. In sintesi, le interfacce multimodali aprono grandi opportunità, ma richiedono attenzione ai bias e una governance che protegga la privacy e la verità dei contenuti.

By Raffaella Scelzi

Fonti :

Luciano FLORIDI The fourth revolution. How the infosphere is reshaping human reality, 2014.

Jean BAUDRILLARD, “Videosfera e soggetto frattale” in AA.VV. Videoculture di fine secolo, Napoli, Liguori, 1989.

Marco SENEALDI, Obversione. Media e disidentità, Postmedia Books, 2014.